Novo Algoritmo Aprende Linguagem Apenas Assistindo a Vídeos

O DenseAV, criado por pesquisadores do MIT, consegue entender a linguagem humana associando sinais de áudio e vídeo, sem a necessidade de texto escrito.

Mark Hamilton, doutorando em engenharia elétrica e ciência da computação no MIT e afiliado ao Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL), está desenvolvendo uma máquina para entender como os animais se comunicam. Para isso, ele primeiro criou um sistema capaz de aprender a linguagem humana “do zero”.

“A inspiração surgiu curiosamente do filme ‘A Marcha dos Pinguins‘. Existe uma cena em que um pinguim escorrega no gelo e emite um som ao se erguer. Observando isso, parece quase evidente que esse som simboliza uma palavra. Foi aí que tivemos a ideia de utilizar áudio e vídeo para aprender a linguagem”, explica Hamilton. “Será que um algoritmo poderia assistir televisão o dia inteiro e, com isso, aprender sobre o que estamos conversando?”

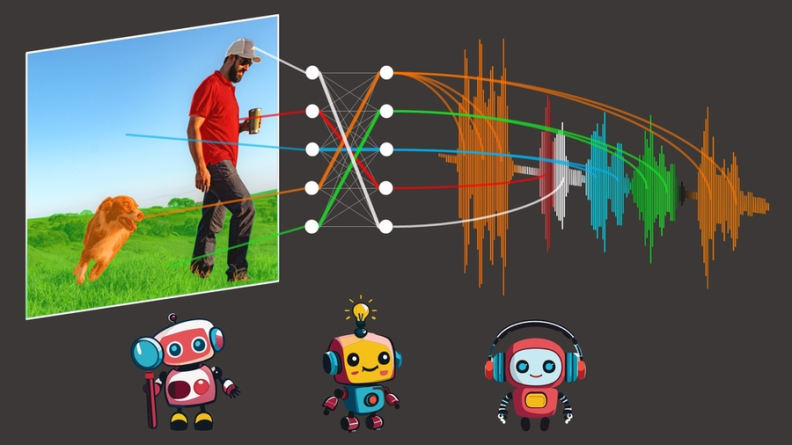

O modelo desenvolvido, chamado DenseAV, aprende a linguagem prevendo o que está vendo a partir do que está ouvindo, e vice-versa. Por exemplo, se ouve alguém dizendo “assar o bolo a 350”, provavelmente verá um bolo ou um forno. Para ter sucesso nesse jogo de correspondência áudio-vídeo através de milhões de vídeos, o modelo precisa aprender sobre o que as pessoas estão falando.

Após treinar o DenseAV nesse jogo de correspondência, Hamilton e seus colegas analisaram quais pixels o modelo procurava ao ouvir um som. Por exemplo, ao ouvir a palavra “cachorro”, o algoritmo começava imediatamente a procurar cães no fluxo de vídeo. Observando os pixels selecionados pelo algoritmo, é possível descobrir o que o algoritmo entende por uma palavra.

Interessantemente, o mesmo processo ocorre quando o DenseAV ouve um latido: ele procura um cão no vídeo. “Isso despertou nosso interesse. Queríamos ver se o algoritmo sabia a diferença entre a palavra ‘cachorro’ e um latido”, diz Hamilton. A equipe investigou isso dando ao DenseAV um “cérebro de dois lados”. Descobriram que um lado focava naturalmente na linguagem, como a palavra “cachorro”, enquanto o outro focava em sons como latidos. Isso mostrou que o DenseAV aprendeu não apenas o significado das palavras e a localização dos sons, mas também a distinguir entre esses tipos de conexões cruzadas, tudo sem intervenção humana ou qualquer conhecimento de linguagem escrita.

Uma aplicação potencial é aprender com a enorme quantidade de vídeos publicados na internet diariamente. “Queremos sistemas que possam aprender com grandes quantidades de conteúdo em vídeo, como vídeos instrutivos”, afirma Hamilton. “Outra aplicação empolgante é entender novas linguagens, como a comunicação de golfinhos ou baleias, que não possuem uma forma escrita. Esperamos que o DenseAV possa nos ajudar a entender essas linguagens que têm escapado dos esforços de tradução humana desde sempre. Finalmente, esperamos que este método possa ser usado para descobrir padrões entre outros pares de sinais, como os sons sísmicos da Terra e sua geologia.”

A equipe enfrentou o desafio de aprender linguagem sem qualquer entrada de texto, visando redescobrir o significado da linguagem a partir de uma tela em branco, sem usar modelos de linguagem pré-treinados. Esse método, inspirado na forma como as crianças aprendem, utiliza dois componentes principais para processar dados de áudio e visual separadamente. Essa separação impede que o algoritmo trapaceie, permitindo que o lado visual olhe para o áudio e vice-versa. Isso forçou o algoritmo a reconhecer objetos e criar características detalhadas e significativas para ambos os sinais.

O DenseAV aprende comparando pares de sinais de áudio e visual para encontrar quais correspondem e quais não. Esse método, chamado de aprendizado contrastivo, não requer exemplos rotulados, permitindo que o DenseAV descubra os padrões preditivos importantes da linguagem por si só.

Uma diferença significativa entre DenseAV e algoritmos anteriores é que os trabalhos anteriores focavam em uma única noção de similaridade entre som e imagens, correspondendo um clipe de áudio inteiro a uma imagem inteira. Isso não permitia descobrir detalhes refinados, como a conexão entre a palavra “grama” e a grama sob o cachorro. O algoritmo da equipe procura e agrega todas as correspondências possíveis entre um clipe de áudio e os pixels de uma imagem. Isso não apenas melhorou o desempenho, mas permitiu a localização precisa dos sons de uma maneira que os algoritmos anteriores não conseguiam. “Métodos convencionais usam um único token de classe, mas nossa abordagem compara cada pixel e cada segundo de som. Esse método detalhado permite que o DenseAV faça conexões mais precisas para uma melhor localização”, explica Hamilton.

Os pesquisadores treinaram o DenseAV no AudioSet, que inclui 2 milhões de vídeos do YouTube. Eles também criaram novos conjuntos de dados para testar o desempenho do modelo na ligação de sons e imagens. Nesses testes, DenseAV superou outros modelos de ponta em tarefas como identificar objetos a partir de seus nomes e sons, provando sua eficácia.

No futuro, a equipe pretende criar sistemas que possam aprender com grandes quantidades de dados apenas de vídeo ou áudio. Isso é crucial para novos domínios onde há muitos dados de um modo, mas não do outro. Eles também pretendem expandir isso usando arquiteturas maiores e possivelmente integrar conhecimentos de modelos de linguagem para melhorar o desempenho.

“Reconhecer e segmentar objetos visuais em imagens, bem como sons ambientais e palavras faladas em gravações de áudio, são problemas difíceis por si só. Historicamente, os pesquisadores têm contado com anotações caras fornecidas por humanos para treinar modelos de aprendizado de máquina para realizar essas tarefas”, diz David Harwath, professor assistente de ciência da computação na Universidade do Texas em Austin, que não participou do trabalho. “DenseAV faz progressos significativos no desenvolvimento de métodos que podem aprender a resolver essas tarefas simultaneamente, simplesmente observando o mundo através da visão e do som — com base na ideia de que as coisas que vemos e interagimos frequentemente fazem sons, e também usamos a linguagem falada para falar sobre elas. Este modelo não faz suposições sobre a língua específica que está sendo falada e, portanto, em princípio, poderia aprender a partir de dados em qualquer idioma. Seria empolgante ver o que DenseAV poderia aprender ao expandi-lo para milhares ou milhões de horas de dados de vídeo em diversos idiomas.”

Autores adicionais do artigo que descreve o trabalho são Andrew Zisserman, professor de engenharia de visão computacional na Universidade de Oxford; John R. Hershey, pesquisador do Google AI Perception; e William T. Freeman, professor de engenharia elétrica e ciência da computação do MIT e investigador principal do CSAIL. A pesquisa foi apoiada, em parte, pela National Science Foundation dos EUA, uma Royal Society Research Professorship, e um EPSRC Programme Grant Visual AI. Este trabalho será apresentado na IEEE/CVF Computer Vision and Pattern Recognition Conference este mês.

Texto adaptado de artigo original de MIT NEWS